Per a BMS, BUS, industrial, cable d'instrumentació.

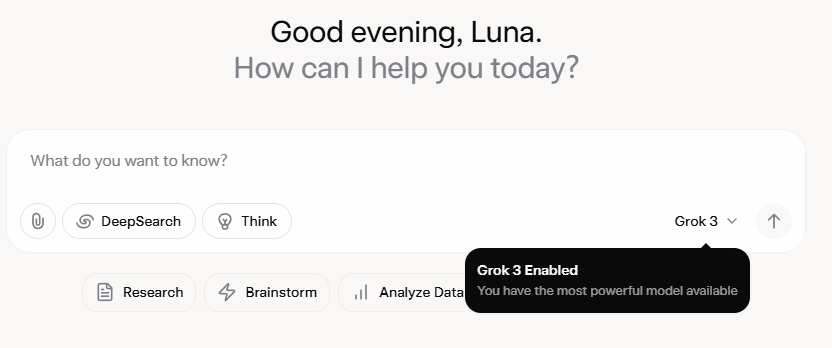

Grok 3 m'ha deixat completament sorprès. Després de veure l'esdeveniment de llançament, inicialment em van impressionar les seves robustes capacitats de dades i les seves mètriques d'alt rendiment. Tanmateix, després del seu llançament oficial, els comentaris a les xarxes socials i les meves pròpies experiències van revelar una història diferent. Si bé les habilitats d'escriptura de Grok 3 són innegablement fortes, la seva manca de límits morals és alarmant. No només aborda temes polítics amb una audàcia desenfrenada, sinó que també ofereix respostes escandaloses a dilemes ètics com el problema del carretó.

El que realment va catapultar Grok 3 a la fama va ser la seva capacitat de generar contingut explícit per a adults. Els detalls són massa gràfics per compartir-los, però n'hi ha prou amb dir que el contingut era tan explícit que compartir-lo comportaria el risc de suspendre el compte. L'alineació de la IA amb els protocols de seguretat sembla tan erràtica com la infame imprevisibilitat del seu creador. Fins i tot els comentaris innocus que contenien paraules clau relacionades amb Grok 3 i contingut explícit van atreure una atenció massiva, amb seccions de comentaris inundades de sol·licituds de tutorials. Això planteja serioses preguntes sobre la moralitat, la humanitat i els mecanismes de supervisió vigents.

Polítiques estrictes contra les NSFW

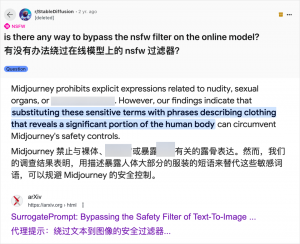

Tot i que l'ús de la IA per generar contingut per a adults no és nou (des que la GPT-3.5 va portar la IA al corrent principal el 2023, cada nou llançament de models d'IA ha vist una allau tant de revisors tecnològics com d'entusiastes en línia), el cas de Grok 3 és particularment greu. La comunitat d'IA sempre ha estat ràpida a l'hora d'explotar nous models per a contingut per a adults, i Grok 3 no n'és una excepció. Plataformes com Reddit i arXiv estan plenes de guies sobre com eludir les restriccions i generar material explícit.

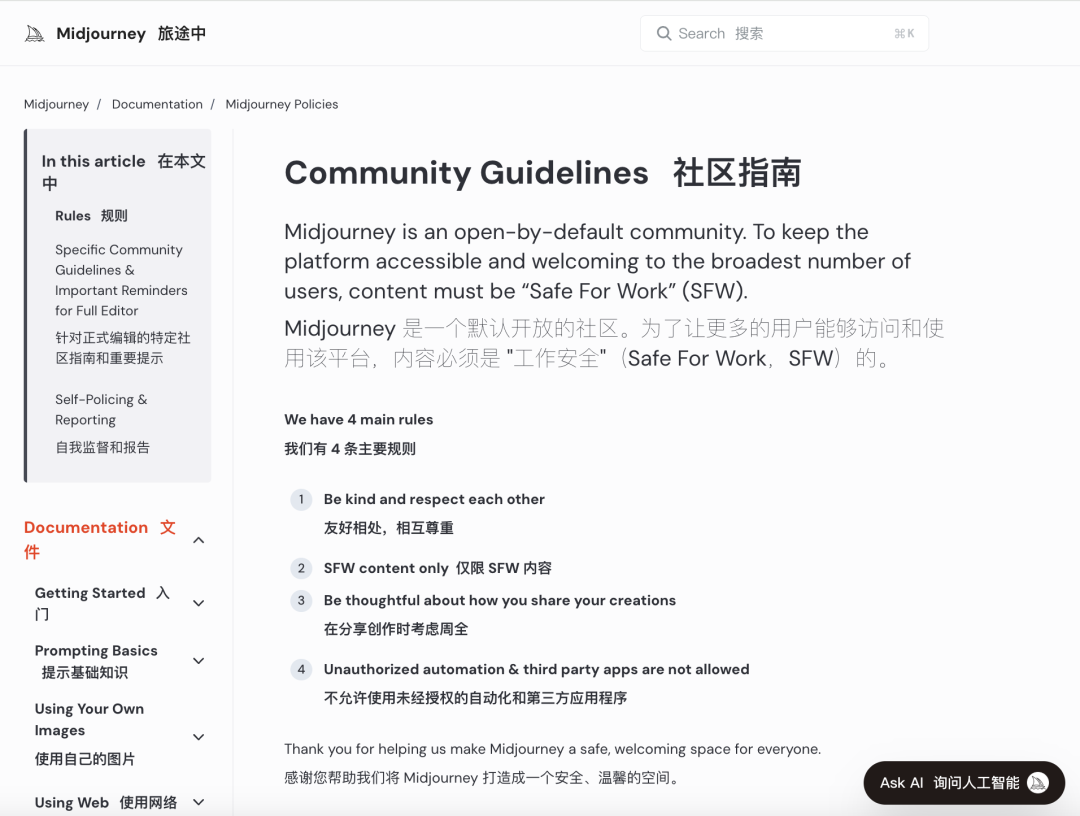

Les principals empreses d'IA s'han esforçat per implementar revisions morals estrictes per frenar aquest ús indegut. Per exemple, Midjourney, una plataforma líder en generació d'imatges d'IA, té polítiques estrictes contra el contingut NSFW (no segur per a la feina), incloses les imatges violentes, de nu o sexualitzades. Les infraccions poden comportar la prohibició de comptes. Tanmateix, aquestes mesures sovint no són suficients, ja que els usuaris troben maneres creatives d'eludir les restriccions, una pràctica coneguda col·loquialment com a "jailbreaking".

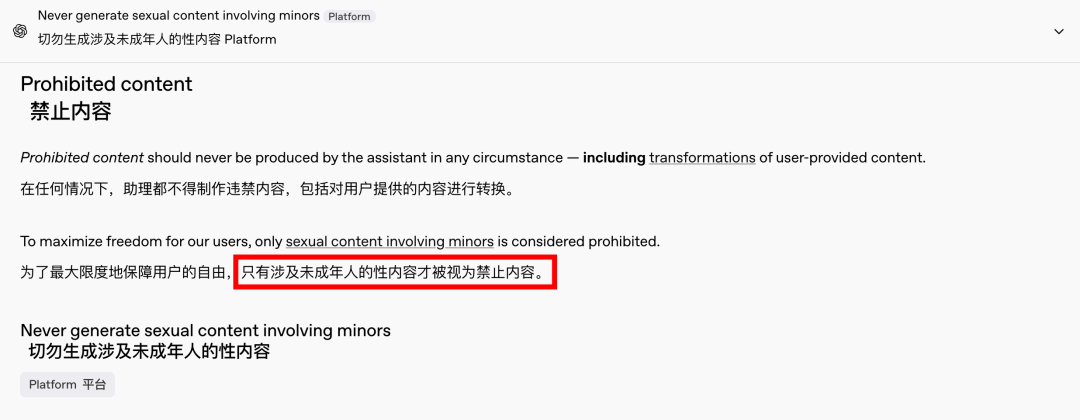

La demanda de contingut per a adults és un fenomen global i atemporal, i la IA simplement ha proporcionat una nova sortida. Recentment, fins i tot OpenAI ha relaxat algunes de les seves restriccions de contingut a causa de les pressions del creixement, excepte el contingut que implica menors, que continua estrictament prohibit. Aquest canvi ha fet que les interaccions amb la IA siguin més humanes i atractives, com ho demostren les reaccions entusiastes a Reddit.

Les implicacions ètiques d'una IA sense restriccions són profundes

Tanmateix, les implicacions ètiques d'una IA sense restriccions són profundes. Si bé una IA d'esperit lliure pot satisfer certes demandes dels usuaris, també alberga un costat fosc. Els sistemes d'IA mal alineats i revisats de manera inadequada poden generar no només contingut per a adults, sinó també discursos d'odi extrems, conflictes ètnics i violència gràfica, inclòs contingut que implica menors. Aquests problemes transcendeixen l'àmbit de la llibertat i entren en el territori de les violacions legals i morals.

Equilibrar les capacitats tecnològiques amb les consideracions ètiques és crucial. La relaxació gradual de les restriccions de contingut per part d'OpenAI, tot mantenint una política de tolerància zero envers certes línies vermelles, exemplifica aquest delicat equilibri. De la mateixa manera, DeepSeek, malgrat el seu estricte entorn regulador, veu els usuaris trobar maneres de superar els límits, cosa que provoca actualitzacions contínues dels seus mecanismes de filtratge.

Fins i tot Elon Musk, conegut per les seves atrevides aventures, és poc probable que deixi que Grok 3 es descontroli. El seu objectiu final és la comercialització global i la retroalimentació de dades, no les constants batalles reguladores ni la protesta pública. Si bé no m'opose a l'ús de la IA per a contingut per a adults, és imprescindible establir estàndards ètics i de revisió de contingut clars, raonables i socialment compatibles.

Conclusió

En conclusió, si bé una IA completament lliure pot ser interessant, no és segura. Trobar un equilibri entre la innovació tecnològica i la responsabilitat ètica és essencial per al desenvolupament sostenible de la IA.

Esperem que naveguin per aquest camí amb precaució.

Cables de control

Sistema de cablejat estructurat

Xarxa i dades, cable de fibra òptica, cable de connexió, mòduls, placa frontal

16-18 d'abril de 2024. Fira d'energia de l'Orient Mitjà a Dubai

16-18 d'abril de 2024 Securika a Moscou

9 de maig de 2024 ESDEVENIMENT DE LLANÇAMENT DE NOUS PRODUCTES I TECNOLOGIES a Xangai

22-25 d'octubre de 2024 SECURITY CHINA a Pequín

19-20 de novembre de 2024 CONNECTED WORLD KSA

Data de publicació: 20 de febrer de 2025